1.非言語情報 ― 豊かな遠隔コミュニケーション実現に向けての鍵

コロナ禍で急速に広まったビデオ会議やVR を用いたメタバースなどのオンラインコミュニケーションで,非言語情報がうまく伝達できないことによる様々な不具合やもどかしさが露見した.コロナ禍後も,SDGsの環境・国境・経済的な面での2030年までのいくつかの目標達成に向けて,また多様な働き方を実現する手段として,オンラインコミュニケーションはさらに重要視されている.

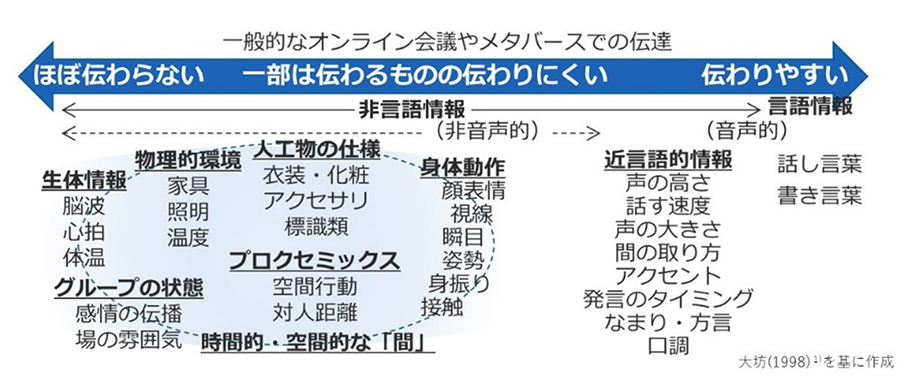

非言語情報は,対人コミュニケーションで使われる情報のうち,言語的な情報(話し言葉や書き言葉)以外の多岐に及ぶ情報を指す.言語情報を補足し,情動の伝達に適しており,他者の真意を読み取る際には言語よりも頼りになることも多い.日常の対人コミュニケーションの中で,感情を伝える場面では9割を超す情報が言葉ではなく非言語情報によって伝達されるという報告もある等,我々の日常の対人コミュニケーションの中で重要な役割を担っている.図1に示すように非言語情報は非常に多岐に及び,一般的なオンライン会議やメタバースなどで比較的伝わりやすいものからほぼ伝わらないものまで幅が広い.そのため,単純な従来手法では欠落してしまう非言語情報を何とかうまく伝送する方法を考えて行くことが,未来社会での豊かな遠隔コミュニケーション実現に向けて重要なテーマとなるのではないかと考える.

多岐に及ぶ非言語情報の中で,顔表情はカメラ映像などによって従来のオンライン会議などでも比較的伝達され易く,また,心理学の分野を中心に顔表情からの感情理解などの研究も盛んに進められており,その利用例も見かける.そういったものの中で最もよく用いられている基盤的理論は,Facial Action Coding System(顔面動作符号化システム)と呼ばれるもので,顔の動きを包括的に定量化し,Action Unit などと呼ばれる基本動作の組み合わせで様々な顔の動きをコード化し,顔の感情認識などに用いられている2).これに対して人の身体動作は,多くの重要な潜在的情報を含むにも関わらず,カメラだけでは必ずしも全てを捉えられず,表現される重要な情報が相手側に届きにくく,また顔表情に比べて研究も十分に進んでいるとは言えず3),学術的にも挑戦的な課題と言える.

2. 身体動作に注目した「動作ユニット」

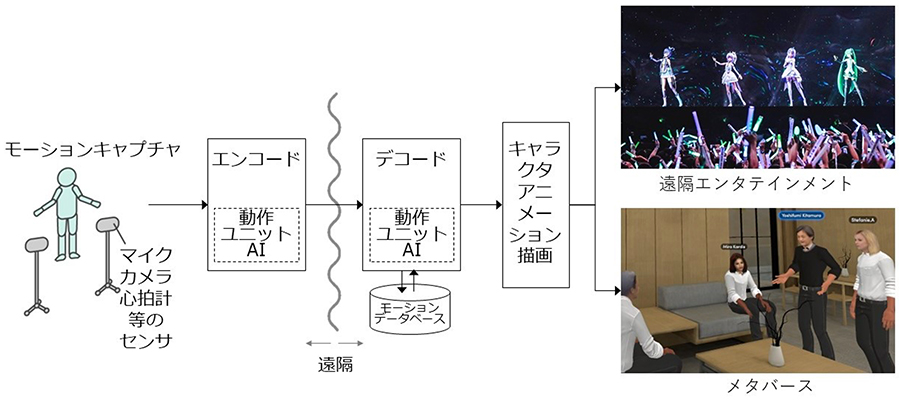

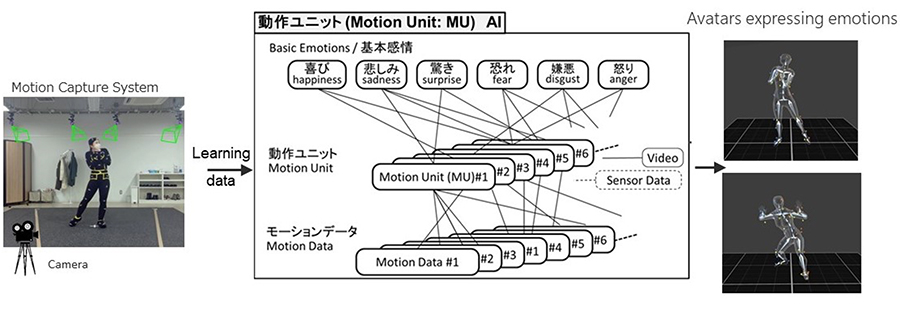

そこで我々は,「人の身体動作」に注目して研究を2021年後半から開始した.上述の顔表情理解研究におけるAction Unit に倣って,身体動作の基本部分単位を「動作ユニット(Motion Unit)」として新しく定義し,その動作ユニットの活動と感情表出の関係を対応付けたAIを作成して,アバタやキャラクタの感情豊かな動作を生成しようとする研究で,心理学やコンピュータアニメーションの分野との学際的研究として実施している.図2に示すように,人の身体動作から感情を推定し,それを基に動作をコード化して伝送し,遠隔地でデコードして取り出した動作をアバタに施せば,通信路に負担をかけることなく,通信環境の変化にロバストに,感情豊かな動作をアバタにさせることができ,豊かな遠隔コミュニケーションを実現できると考える.

動作ユニットを定義する目的は,感情を表出する人の身体動作を客観的・体系的に記述するために必要となる関節の運動要素とその組合せを最小限のレベルで明示・リスト化することで,世界中の研究者たちが用いることのできる共通言語を作成することである.そのために,我々は現在モーションキャプチャ装置を使ってデータの取得を進めている.動作ユニットを定義する際に参考となる身体動作による感情表出についての先行研究は,The Body Action Posture coding system 4)など極めて少数に限られる.そこで,モーションキャプチャから得られる大規模データを利用して,2 段階のデータ駆動型アプローチを採用することとした.まず第1 段階では図3のように,感情表出に必要となる動作とそのための分析単位を抽出することにより,どのような感情表出にどのような身体動作が必要になるのかを見出すことができる.そして第2 段階として,表情研究における顔表情生成器のように動作ユニットを操作する身体動作生成器を構築し,どのような動作ユニットの動きの組合せがどのような感情表出に見えるのかを検証する.

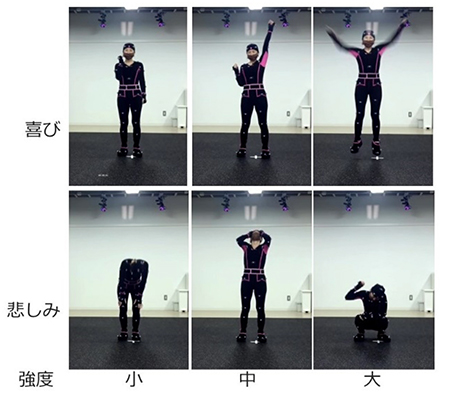

身体動作のデータとしては,舞台等に出演しているプロ(または準プロ)の役者100名を雇い,全員にそれぞれ12 種類の感情(喜び,悲しみ,怒り,嫌悪,恐れ,驚き,軽蔑,感謝,罪悪,嫉妬,誇り,羞恥)のそれぞれに対応するシナリオの元で小・中・大の3段階の感情表出強度で演じ分けてもらっている.その例を図4に示す.これにニュートラル(無感情)の表出を加えて1 人当たり111 の動作データを取得する実験は,1人につき優に半日かかる.2022年12月現在,ほぼ100名分のデータ取得を終え,現在解析中である5).

次回に続く-

参考文献

- 大坊郁夫: しぐさのコミュニケーション,サイエンス社, 1998年9月

- Ekman, P., & Friesen, W. V: Facial action coding system (FACS): A technique for the measurement of facial action. Palo Alto, CA: Consulting Psychologists Press, 1978.

- Witkower, Z. and Tracy, J. L: Bodily Communication of Emotion: Evidence for Extrafacial Behavioral Expressions and Available Coding Systems, Emotion Review, 11(2), pp.184–193, 2019.

https://doi.org/10.1177/1754073917749880 - Dael, N., Mortillaro, M. and Scherer, K. R: The Body Action and Posture Coding System (BAP): Development and Reliability, Journal of Nonverbal Behavior, 36(2), pp.97–121, 2012.

https://doi.org/10.1007/s10919-012-0130-0 - Cheng, M., Higashiyama, S., Fujiwara, K., Tseng, C. H. Kitamura, Y: E-Motion: A database of bodily Expression of basic and social emotions, iPerception (in press).

【著者紹介】

北村 喜文(きたむら よしふみ)

東北大学 電気通信研究所 教授

■略歴

東北大学 電気通信研究所 教授.博士(工学).バーチャルリアリティやコンピュータヒューマンインタラクションの研究に従事.1987 年大阪大学大学院基礎工学研究科博士前期課程修了.同年キヤノン(株),1992年ATR 通信システム研究所,1997 年大阪大学大学院工学研究科/情報科学研究科 助教授/准教授.2010 年より現職.2018 年より副所長.

藤原 健(ふじわら けん)

國立中正大學 心理學系 助理教授

■略歴

國立中正大學 心理學系 助理教授 / 東北大学 電気通信研究所 非常勤講師.博士(人間科学).社会心理学,対人コミュニケーションの研究に従事.2013 年大阪大学大学院人間科学研究科博士後期課程修了. 同年京都大学経営管理大学院研究員,2014 年大阪経済大学講師,2019 年カリフォルニア大学サンタバーバラ校客員研究員を経て2021 年より現職.

幸村 琢(こうむら たく)

香港大学 コンピュータサイエンス学科 教授

■略歴

香港大学 コンピュータサイエンス学科 教授 / エジンバラ大学 情報学部 教授 / 東北大学 電気通信研究所 客員教授.博士(情報科学).キャラクタアニメーションの研究に従事.2000年東京大学大学院情報理工学系研究科博士後期課程修了.同年理化学研究所研究員,2002年香港城市大学Assistant Professor,2006年エジンバラ大学Lecturer, Readerを経て2019年よりProfessor.2020年より現職.