―日本のロボット開発の現状をどのように見ていらっしゃいますか?

日本のロボット開発は随分と進んでいますが,ロボットを議論する際,産業用ロボットとそれ以外のロボットとに分けて考えないといけません。産業用ロボットでは、プレイバックで同じ動作を繰り返すというものから対象物の状況を把握してそれに合わせて動作する方向へと進んでいます。

そのキーとなるのは、センサーとアクチュエータの高速化です。センサーでは,1/1,000秒(1ms)で高速にデータを出力させるのがポイントの一つとなっています。ロボット用サーボモーターのサンプリングレートでよく使われるのは1ms,2ms,5msあたりですが,このサンプリングレートに合わせたデータを入れるのが要求側の最速値となっています。これに対応してきたのは,これまで力センサーや角度センサーでした。これに対して画像を用いたセンサーはそこまで達していませんでした。それが今では1/1,000秒という高速にデータを処理することができるようになっています。これを搭載した高速・高精度,かつフレキシブルな動作を行なう産業用ロボットがこれからの姿になるでしょう。

一方,AI(人工知能)と関連したロボットがあります。ヒューマノイド型であったり、AIによっていろんなことができたりするロボットです。これらはエンターテイメントをはじめとして応用範囲を広げてはいますが、研究開発段階のものが多く,実際に使えるものとしては実現されているものは多くありません。その理由は,精度など信頼性に問題があるからです。

これをAIの問題ととらえると、人間的な動きをするという考え方がその一つにあります。これは私の考えですが,人間的な動きをするというのがロボットではなくて、ロボットというのは機械システムとして本来の働きをしなければならないと思っています。産業用ロボットは物理的な速度限界はあるものの,動作スピードは速いですが、AI系のロボットは遅いのです。これだと機械システムの性能を無駄遣いしているのではないかと思ってしまいます。では、速度限界に近づけるにはどうしたら良いかということになりますが,その答えは知能を高速化させるということになります。これはなかなか大変なことだろうとは思います。

―では、先生が狙っているところとは?

産業用ロボットの知能を高めていくことです。そのためには,センサーとアクチュエータの高速化,高精度化が重要になります。センサーに関しては,その機能はかなり高まってきていますが,要求速度は先ほど申し上げたように1/1,000秒なので,これに対応するための開発が必要です。特に一般的な光センサーは遅いので、それを如何に高速化させるかが課題です。

光三次元形状計測を例に挙げますが,現在製品化されている多くのものは遅いのが現状です。CEATECに出展しましたが,エクスビジョン(石川氏が創業したベンチャー企業)では1/1,000秒で高速三次元計測を可能にするシステムを開発しています。これは対象物に対し,測定用のパターン画像を1,000fpsで投影可能なプロジェクターと高速ビジョンセンサーを使用することで,高速に移動している物体をリアルタイムで形状計測できるものです。1/1,000秒で認識する高速ビジョンセンサーはロボット制御にもそのまま使うことができます。

―高速ビジョンセンサーについて詳しく教えてください。

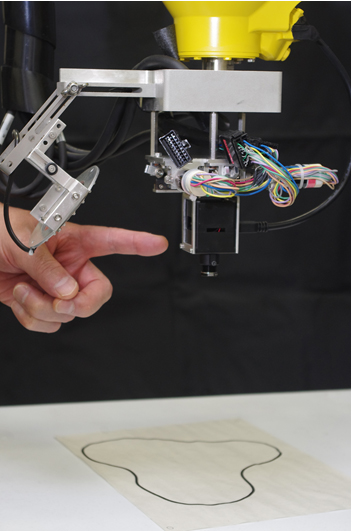

我々の研究室とソニーとが共同で開発したもので,ソニーが実用化を発表しています。この成果をこの2月に開催されたISSCCで発表しましたが,我々の研究室ではこれを搭載したパラレルリンクロボット(ファナック製)を用い,高速画像認識技術などの研究開発を進めています。このチップはcolumn parallelという方式で,1/1,000秒で画像処理ができるものです。1番上の層に1/1,000秒でも感度が高いイメージャーがあり,二層目にAD変換が約1,300個,4bitと1bitプロセッシングエレメント(PE)も約1,300個が並列実装されています。フレームレートは,フル解像度で500 fps(2メガピクセル4 bit)。それを1/4にした0.3メガピクセルで1,000fpsになります。これを例えばGPUでやろうとしたら何十Wという消費電力が必要ですが,このチップはわずか363mWです。

これまで1/1,000秒の画像処理を実現させるのには高価な画像処理装置が必要でしたし,カメラ自体も感度が足りなかったり,足りたとしても分解能が低かったりという問題がありましたが,このセンサーでは感度も分解能も満足するものとなっています。それでいて超低消費電力。私はこの高速ビジョンセンサーが今後のロボットの世界を根底から変えると思っています。なぜならロボットの指先に載せられるので,相対値制御が実現できるからです。そうなるとある程度のずれはローカルに補償できるので,プレイバックという概念がなくなります。これは非常に大きなインパクトがあります。

―具体的にどのようなインパクトがあるのでしょうか?

それはロボットを止める必要がなくなるということです。現状は、ロボットが三次元形状計測を行なう際には毎回動作を止める必要があります。止まって画像計測を行ない,それに合わせて動作し,また画像計測を行なうのに止まるのを繰り返すわけです。その間に揺れてしまうという問題もあります。

それがこの高速ビジョンセンサーを使うと,揺れても1/1,000秒単位の情報がコントローラーに入っているので止まらずに動作することが可能になります。

それともう一つ,我々が取り組んでいるものとしてDynamic Compensation(動的補償)があります。これは大きな動きに対して細かいところは全てローカルのフィードバックに任せるというものです。画像計測が高速であれば本体のダイナミクスを全て補償できるので、筐体がどう動こうが問題になりません。例えばロボットアームの先に取り付けたセンサーで20 mm×20 mmの範囲の動きをフィードバックすれば,相対位置制御によってアームから先の動きは20 mmの精度で良くなるわけです。1/1,000秒の高速画像処理ならびに1/1,000の三次元形状計測ができると、産業用ロボットのフレキシビリティや知能は格段に上がります。

―AI系ロボット側から見るといかがでしょうか?

三次元形状計測は出来ていますが,先ほども申し上げたようにスピードが遅いという問題があります。高速化するにはセンサーのことが分かっていないといけません。いま期待されているのはTOF方式センサーですが,自己位置推定の高速化も必要です。

AIについて、ロボット掃除機「ルンバ」の開発者であるロドニー・ブルックスが随分前に「象はチェスをしない」という論文を発表しました。ここでチェスというのはロジックのAIを指しています。このロジックは組合せの最適化で問題を解くというタイプで、正しいロジックを通じてインテリジェンスを発揮していくというものです。しかし象にそんなロジックは必要ないというのです。象にとっては,リアルワールド・リアルタイムである今の世界をどうやって生きていくかという知能が必要であって、チェスの知能は要らないというわけです。

ロジックの方の知能には,あまり光技術は関係してこないと思います。しかし,リアルタイムの世界では光技術,あるいはセンサー技術が重要となります。いずれもリアルタイムを実現するものです。私はどちらかというと象の方の立場にいますが,近い将来,ロジックとリアルタイムの知能が一体化すると思っています。一体化するためのカギを握っているのは,リアルタイム側の技術です。なので,センサーデバイスの高精度化,高速化は必ず必要です。

AIやIoTを実現するため、ディープラーニングなど色々な知能を埋め込むのも重要ですが、実際にインプリメントする場合には実世界を全て理解していることの方が重要で、そうなるとセンサーの能力が高い方が知能としても高くなります。これが、私が見ているこれからのロボット開発のトレンドと、光センサーを開発されている方々への期待感です。

そのことを理解してAIやIoTを構築する必要があります。これは日本が強いのではないかと思っています。欧米はチェスロボットに代表されるような上の層の知能を上げるという方向に走っていますが,例えば,工場全体を知能化するには,どれだけセンサーをうまく作れたかが重要となります。ですので、日本はセンサーの知能の高度化に迫って行くほうが良いと思います。

―ロボットと光技術との融合の可能性について、どのようにお考えでしょうか

大きく分けて3つの流れがあります。

光センサーが必要であるというのは先ほどから申し上げてきましたが,一つは小型化です。正確に言うと,小型かつ軽量でなくてはなりません。ロボットには可搬重量に制限があるので,大型なセンサーを搭載するわけにはいけません。

二つ目は配線です。ロボットにはセンサーからコントローラーまで必ず配線が通ります。その配線をどうにかして光化できないものかと考えています。電力線の光化は難しいと思いますが,例えば,触覚センサーなど何かしらのセンサーを搭載するとなると膨大な配線が必要になります。これを光通信させることができないかと思っています。自由空間通信になるので難しいところもあるのですが,配線をどうにか光に高度化してロボットの邪魔にならないようにできれば良いと思っています。実は配線の扱いは大変なんです。ロボットが回転すると配線も一緒に回るので、断線する可能性があります。私の研究室でも断線はしょっちゅう起こります(笑)。

また,複数台のロボットをネットワーク化した際の通信も問題となります。ここで必要となるのは光ファイバー通信です。如何にしてレイテンシー(遅延)を最小化させるかという点が重要となります。

三つ目は,空間精度と時間精度を対象にしたセンサーの実現です。我々が研究を進めているデザインコンセプトにダイナミクス制御があります。時間・空間両方のダイナミクスをサンプリング定理以上のところで、全てカバーするという考え方です。サンプリング定理では対象の帯域の倍を計測すれば良いのですが、それ以上のことを時間・空間で計測できるセンサー・システムの構築が望まれています。

対象の変化を理解するために、センサーが対象の時間的変化・空間的変化の周波数帯域を全て取れるようになると,完全把握が可能になります。完全把握ができるということは推測する必要がなくなります。全てがリアルタイムフィードバックでよくなるので,推定が要らない,学習が要らない,予測が要らないことになります。我々が目指しているのは、そういう世界です。その設計論で前提となる完全把握するシステムというのは光技術でないとできないと思っています。

もう一つ挙げるとすれば,光学系の高速化にも期待したいところです。アクティブビジョンやアクティブオプティクスというのがありますが、例えば,焦点距離を可変にするズームレンズの動きは非常に遅い。これを1/1,000秒で実現してもらいたいと思っています。せっかく1/1,000秒のチップができても焦点面だけの話ですよね。絞りはある程度速いのですが、ズームと焦点調節は今のスピードではロボットに足りません。

人間の目がついていけないので高速の電動ズームには意味が無いとよく言われますが,そんなことはありません。例えば国立競技場の8万人の中からブラックリストに載っている人を探しだすには,まず広い範囲を撮ってそれらしい人を見つけたらとヒュッとズームして認識、違ったらまたヒュッ、ヒュッとズームを繰り返します。ズーム一回が1 msくらいでできれば80秒もあれば8万人を確認することができる計算です。ところが一回に1秒かかると60倍違う。それだけ違うと人はその間にいなくなってしまいます。

―先生はセキュリティ分野のご研究もされているのでしょうか?

もちろんメインテーマは高速のロボットです。我々が目指す世界には人間の目をまねたような光センサーではなくて,人間の目を超えてさらに光素子の限界,機械システムの限界を超えるような光センサーが必要です。人間の目で動きが見えるようであればそのロボットは遅いんです。動きが見えるようでは機械の限界に達していない。だから機械の限界に挑戦する。見えないスピードで動かないといけないというのが,私のロボットのイメージです。

(月刊OPTRONICS 2017年12月号より転載)