木下 航一

6.ディープラーニング技術を活用した認識処理

本センサでは近年急速な発展を遂げているディープラーニング技術を活用して、高精度なドライバ状態認識を実現している。以下では本センサで用いているCNNおよびLSTMについて概説する。

6.1 CNN

CNNは従来の全結合型のネットワークと異なり、学習により取得された小領域のフィルタと画像を畳み込み演算を実施する畳み込み層、および畳み込み層で得られた画像を所定のルールで圧縮するプーリング層を幾重にも重ねた構成を持ち、画像の変形に対するロバスト性を向上させたネットワークである。ネットワーク自体は古くから知られていたが、近年の汎化性能を向上させる学習方法の提案により、様々な画像認識系のベンチマークテストの最高性能を更新しており、昨今のディープラーニングブームの牽引役となっている。本センサでは、画像全体からドライバの大まかな姿勢に相当する特徴量を抽出するためにCNNを用いている。

6.2 LSTM

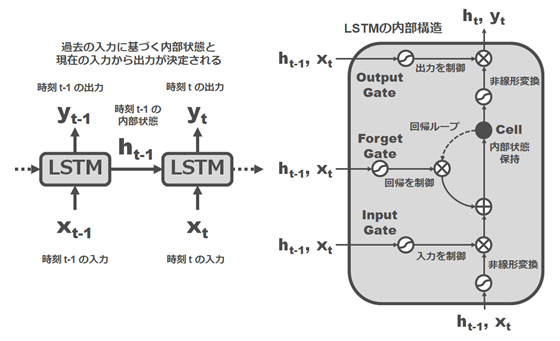

LSTMは入力として時系列データを扱い、所定の1フレームの認識結果を得るために該当フレームの情報に加えて前フレームの中間出力を入力とする。また、セルと呼ばれる内部記憶を保持し、この値によって出力に対する該当フレームの入力の重みを計算する。この重みは事前学習によって挙動が設定されており、従来の再帰型ニューラルネットワークに比べてより長期の記憶が可能になることで知られている。図5にLSTMの概略を示す。

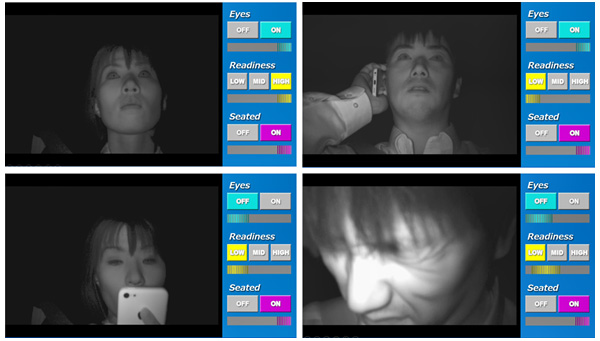

7 運転集中度センシングの認識例

図6に本センサによるドライバ状態の認識結果例をいくつか示す。各画面で左側にドライバの画像、右側にはその時のEyes-on/off、Readiness-high/mid/lowおよびSeated-on/offの3指標による認識結果が表示されている。図6左上は運転中の正常状態、すなわちドライバが前方を監視している状態であり、Eyes-on、Readiness-highおよびSeated-onと認識されている。一方図6右上は運転しながらスマホによる会話を行っている状態であり、この場合視線は前方監視しているためEyes-onとなっているが、緊急事態の際にすぐに運転動作ができる状態ではないため、Readinessはlowとなっている。また左下の例では視線、姿勢とも運転に適さない状態となっておりEyes-off、Readiness-lowと認識される。右下の例も同様である。このように、自動運転中に起こりうるドライバの様々な動作を、「運転に責任が持てる状態か」を識別するための3指標で評価し、リアルタイム認識することが可能である。

(左上)前方監視(右上)スマホ会話(左下)スマホ操作(右下)体調異変

8.おわりに

画像による車載センサによるドライバ状態のセンシング技術について、われわれの技術を例に取り上げ解説を行った。事故防止、あるいは快適な運転環境実現のために、これらの技術は今後ますます重要性が高まってくるものと考えられる。また本稿では触れなかったが、他の測定情報(たとえば脈拍、体温、ステアリング履歴等)の活用、意識低下時等のドライバへの効果的な働きかけ手法など、安全・快適な自動運転システムを実現する上で必要であると考えられる技術要素は数多く存在する。今後は各要素技術の性能向上はもちろん、これらの技術を有機的に組み合わせる取組みも重要になってくるものと考えられる。